被称为科技“春晚”的大会之一的GTC带来了哪些颠覆性的产品?

今日凌晨,黄仁勋穿着标志性皮夹克,登上演唱会般布局的舞台。站在舞台中央,黄仁勋先是用一张图回顾了英伟达的发展历史,期间还着重提了下自己亲自讲首台DGX One送给OpenAI的故事。

随即,黄仁勋向开发者英伟达最新一代产品和最新进展——在这场两个小时的演讲中,黄仁勋公布了搭载B200芯片的GB200 Grace Blackwell超级芯片系统,以及英伟达在AI软件(NIM微服务)、Omiverse云、具身智能方面的最新进展。

作为Hopper 的继任者,Blackwell B200这颗重磅炸弹实现了怎样的代际飞跃?黄仁勋宣布的GR00T的项目,意欲在机器人和具身智能做出哪些突破性工作?英伟达成为业界公认的“产业风向标”,又一次将人工智能行业推向又一个先锋时刻?以下,Enjoy:

1

强势发布「新作」

英伟达持续探索科技的边界

Hopper的继任者——算力炸弹Blackwell B200来袭!

几乎每六个月就翻一番的大型语言模型,让算力成为了行业必需,也让英伟达GPU成了抢手货。

这次GTC,英伟达再次发布新品“Blackwell B200”,以继承Grace Hopper的位置,成为下一代数据中心和AI GPU。

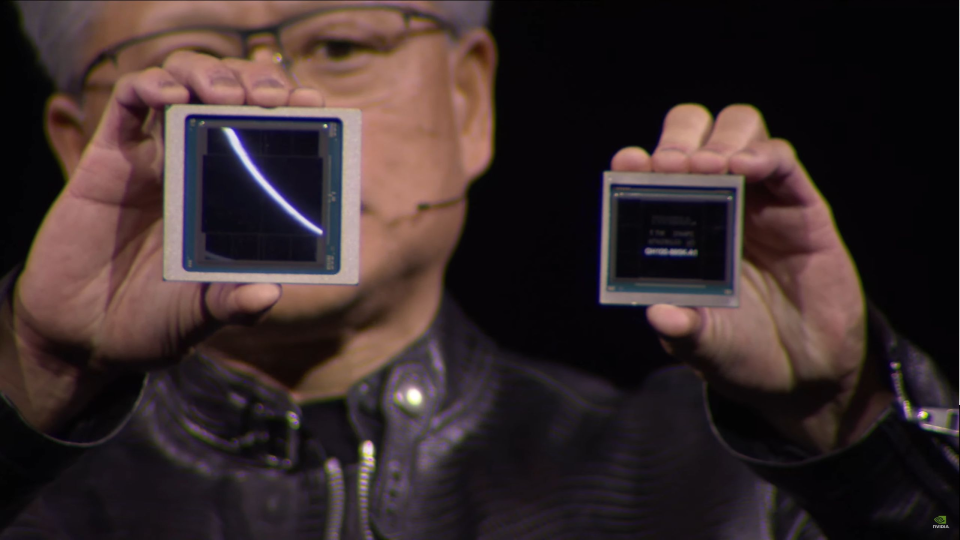

Blackwell和Hopper的对比

黄仁勋表示:“Hopper很棒,但我们需要更大的GPU。”

Blacewell B200也确实从各种意义上完成了「继承」与「超越」:

保留 Grace CPU 架构,同时能够与更新的 Blackwell GPU 进行配对。

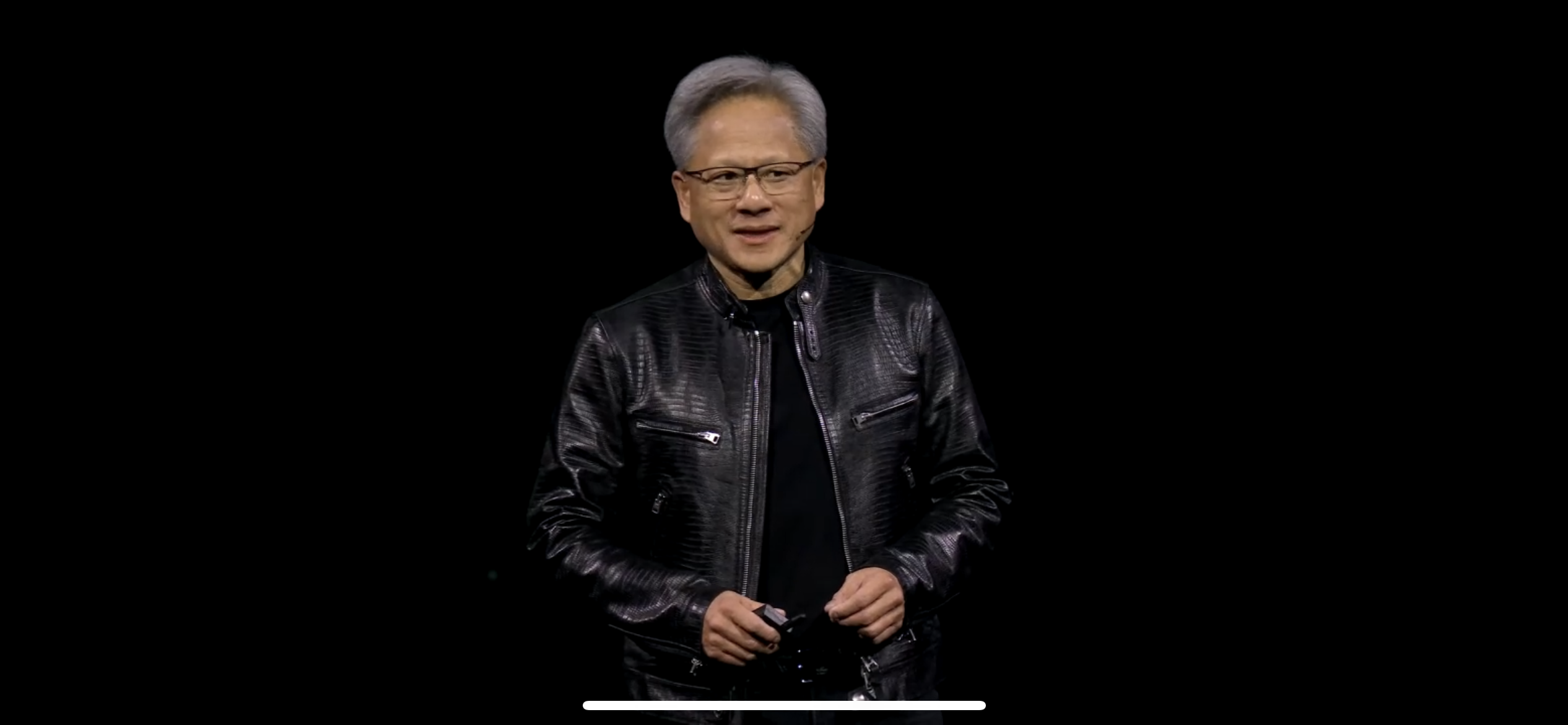

世界上晶体管数量最多的芯片,包含2080亿晶体管,是H100的两倍多。

第二代Transformer引擎,至多可以提供的4 petaflops的AI计算,提升了推理能力和模型大小。

使用台积电定制4NP TSMC工艺加持,支撑双芯片配置,是对Hopper H100的改进版本。

配备18个第五代NVLink连接,是H100链接数量的18倍。能够提供高达1.8TB/s的双向吞吐量,可以支撑大规模GPU间的高速通信。

配备 192GB HBM3e 内存,足以提供高达 8 TB/s 的带宽。

老黄在现场也展示了Grace-Blackwell系统(两个Blackwell GPU、四个die与一个Grace Cpu连接在一起)。GB200能够将两个B200 Blackwell GPU与一个基于Arm的Grace CPU进行配对。

还有专门为 AI 训练推出的 GB200 NVL72 机群,它将 36 个 CPU 和 72 个 GPU 插入一个单一的液冷机架中,总共有 720 petaflops 的 AI 训练性能或 1440 petaflops(也称为 1.4 exaflops)的推理能力。内部有近两英里长的电缆,有 5000 根独立电缆,包含 72 个 Blackwell GPU 和 36 个 Grace CPU,通过第五代 NVLink 互连。

英伟达表示,该系统可以部署一个拥有 27 万亿参数的模型,而 GPT-4 大约是一个拥有 1.7 万亿参数的模型。据称,亚马逊、谷歌、微软和甲骨文都已计划在其云服务产品中提供 NVL72 机架。

老黄对新芯片信心满满,并表示,人工智能是经济发生根本性变革的驱动力,而Blackwell芯片将成为“推动这场新工业革命的引擎”。他预计,Blackwell支持构建实时生成式AI的性能将有用武之地。许多组织都将采用Blackwell,例如亚马逊网络服务、戴尔、谷歌、Meta、微软、OpenAI、甲骨文、特斯拉和XAI等等。

如同Wedbush Securities分析师Dan Ives曾表示:“这代表着人工智能行业展望未来的又一个先锋时刻。”

不过,英伟达没有提供新款GB200或其使用系统的成本。据分析师估计,英伟达基于Hopper的H100芯片成本在2.5万至4万美元之间,而整个系统的成本高达20万美元。

NIM+NeMo:英伟达版企业用GPTs来了?

芯片炸弹以外,英伟达用软件再次给AI行业带来「亿点点」震撼。

发布会上,英伟达推出了集大成的新服务,也是新创收产品:NVIDIA NIM。

它甚至可以让企业“简单粗暴”地部署并利用使用自己数据打造的专属模型。

NIM支持使用旧的英伟达GPU进行推理,并允许公司继续使用他们已经拥有的数亿个英伟达GPU。

NIM的出场,让新人工智能模型的初始训练推理所需的算力更少。从商业策略角度来看,购买英伟达服务器的客户需要注册英伟达企业版,每个GPU每年收取费用4500美元。

黄仁勋表示,该软件还将帮助在配备GPU的笔记本电脑上运行人工智能,而不是在云服务器上运行。这又为客户提供了坚持使用英伟达芯片的理由,将英伟达生态环环相扣。

据英伟达高管表示,该公司正逐步从纯粹的芯片供应商转变为平台提供商,类似微软或苹果。

计算光刻平台

发布会上,英伟达还宣布台积电和新思科技(Synopsys)正推进部署使用英伟达的计算光刻平台。台积电和新思科技已决定在其软件、制造工艺和系统中集成英伟达的 cuLitho 计算光刻平台,加快芯片制造速度,并在未来支持最新一代英伟达 Blackwell 架构 GPU,以加速制造并推动下一代先进半导体芯片的物理极限。

NVIDIA 创始人兼首席执行官黄仁勋表示:“计算光刻技术是芯片制造的基石。我们与 TSMC 和 Synopsys 围绕 cuLitho 展开合作,通过加速计算和生成式 AI 为半导体微缩开辟了新的方向。”

英伟达还推出了全新的生成式人工智能算法,增强了用于 GPU 加速计算光刻技术的库 cuLitho,相比较目前基于 CPU 的方法,显著改善了半导体制造工艺。

英伟达开发了应用生成式人工智能的算法,以进一步提升 cuLitho 平台的价值。在通过 cuLitho 实现的加速流程基础上,新的生成式人工智能工作流程还能额外提高 2 倍的速度。

英伟达表示 cuLitho 的优势已经在台积电生产过程中显现,两家公司共同实现了曲线流程速度(curvilinear flows)提高 45 倍,传统的曼哈顿式流程(traditional Manhattan-style flows)提高近 60 倍。

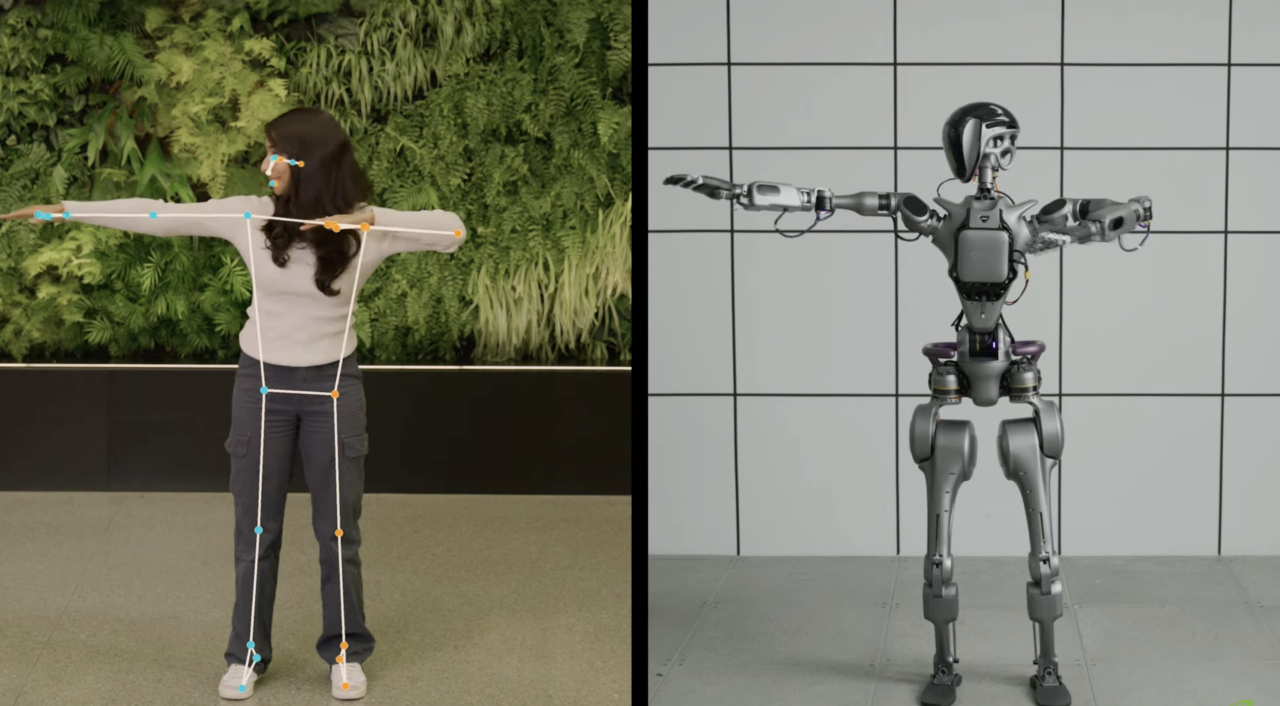

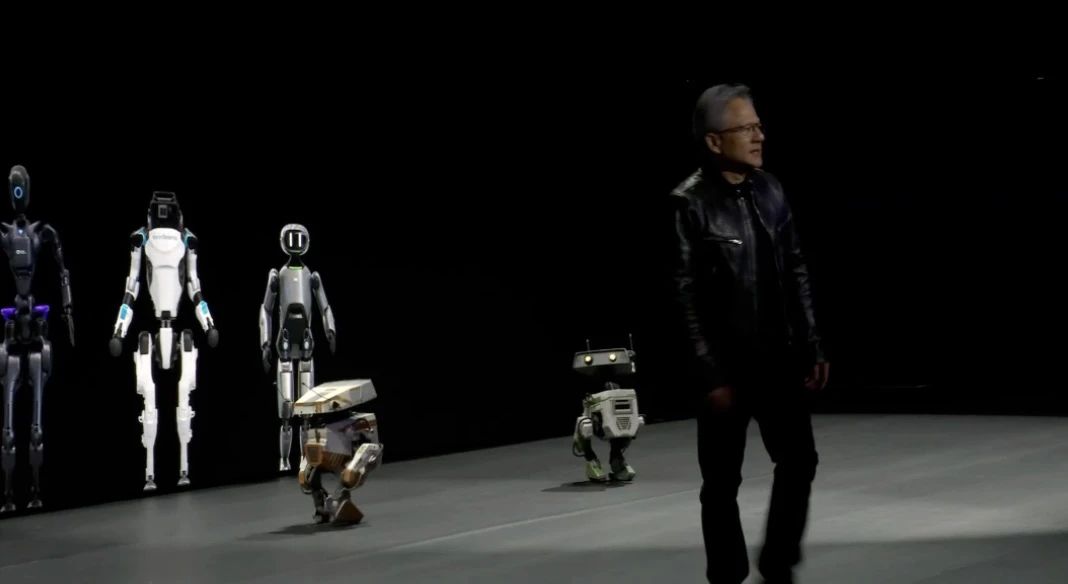

Project GR00T 人形机器人

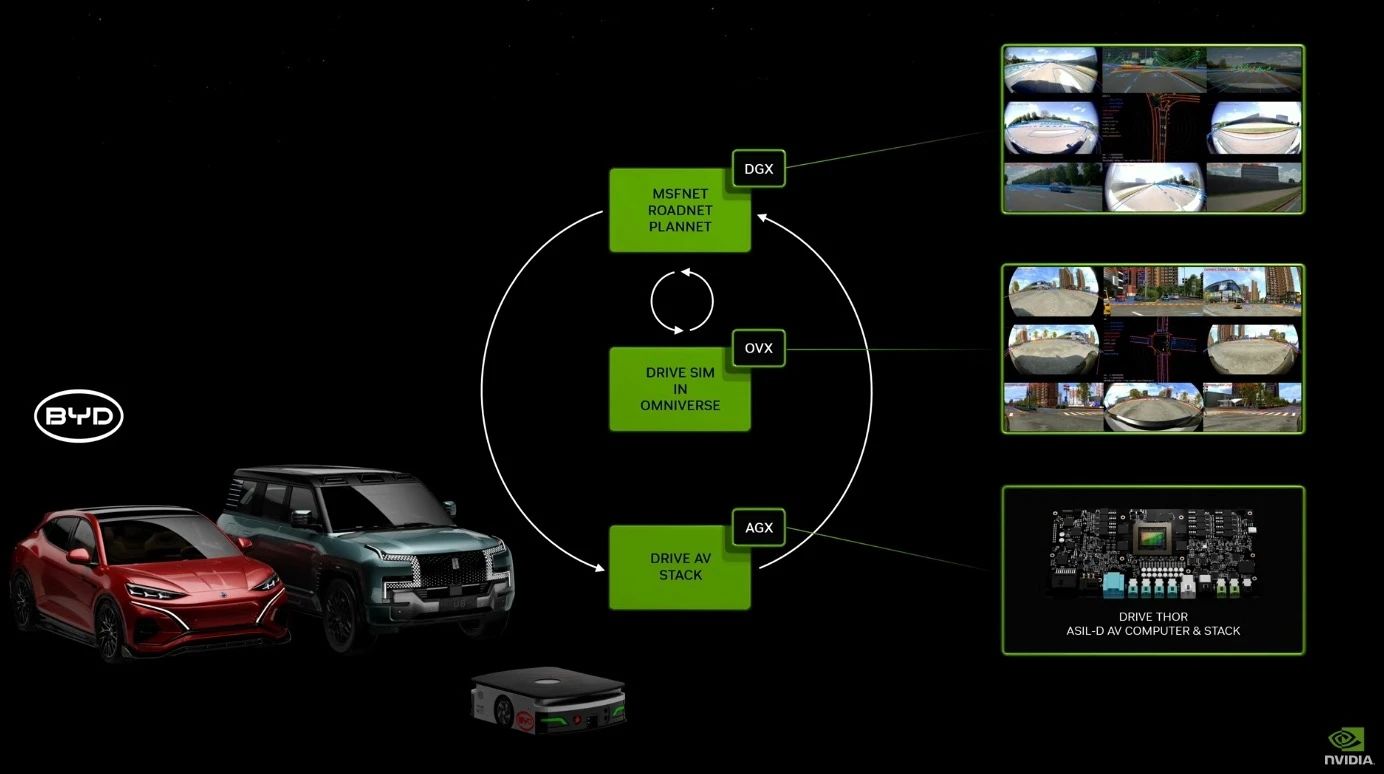

英伟达目前正在构建包括NVIDIA IAI、Omniverse、ISAAC三大与机器人产业高度关联的平台。

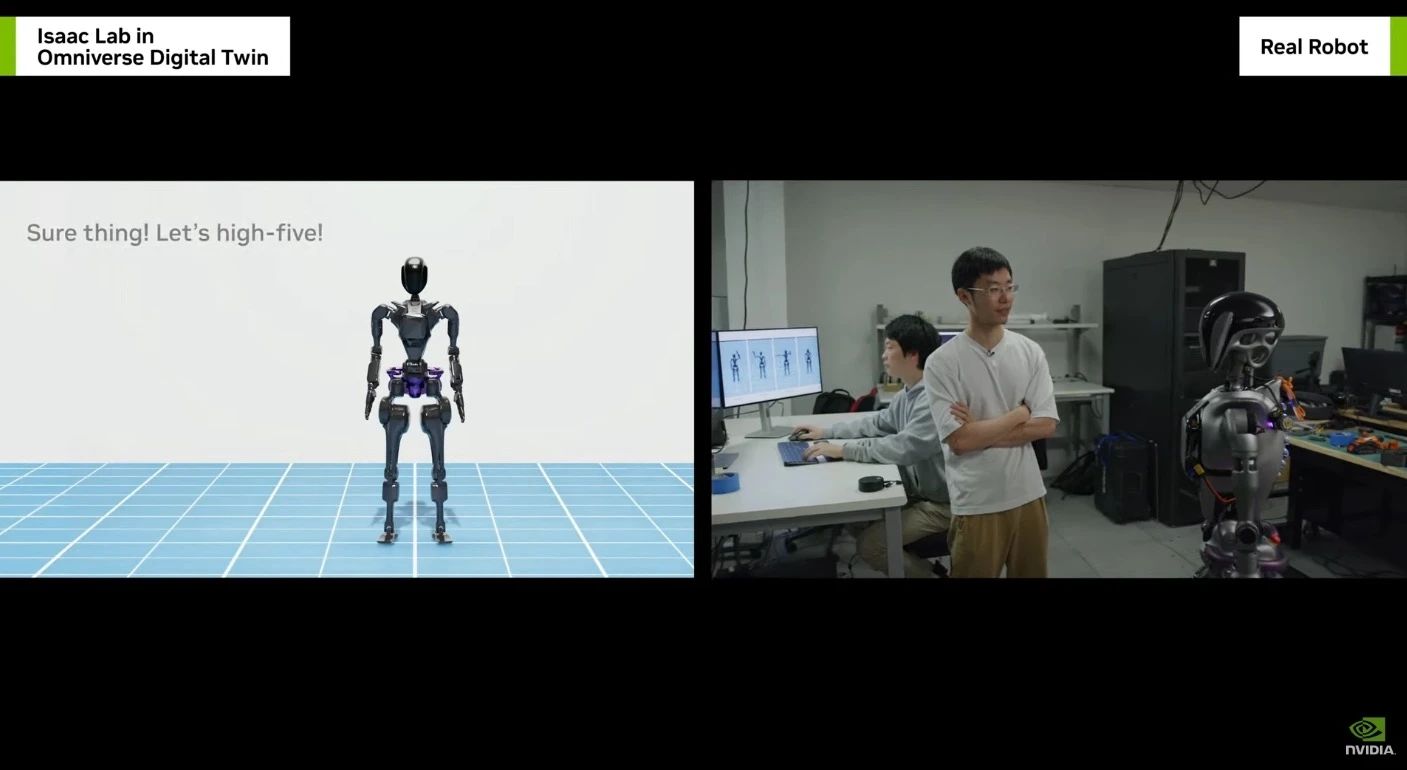

发布会上,黄仁勋推出了Project GR00T 人形机器人项目。GR00T 脱胎于英伟达的 Isaac 机器人平台工具,基于新的通用基础模型,GR00T 驱动的人形机器人能够接受文本、语音、视频甚至现场演示的输入,并对其进行处理以采取特定的操作,包括理解自然语言、模拟人类行为、在现实世界中导航和交互。

同时,基于英伟达Omniverse构建的ISAAC Lab也进行了同步更新。

同时,NVIDIA Omniverse Cloud将可以连接到苹果公司混合头显Vision Pro。

ISAAC Lab还整合了用于辅助提升机械臂的灵敏度与精确度的加速库平台ISAAC MANIPULATOR,以提升机器人的感知能力。

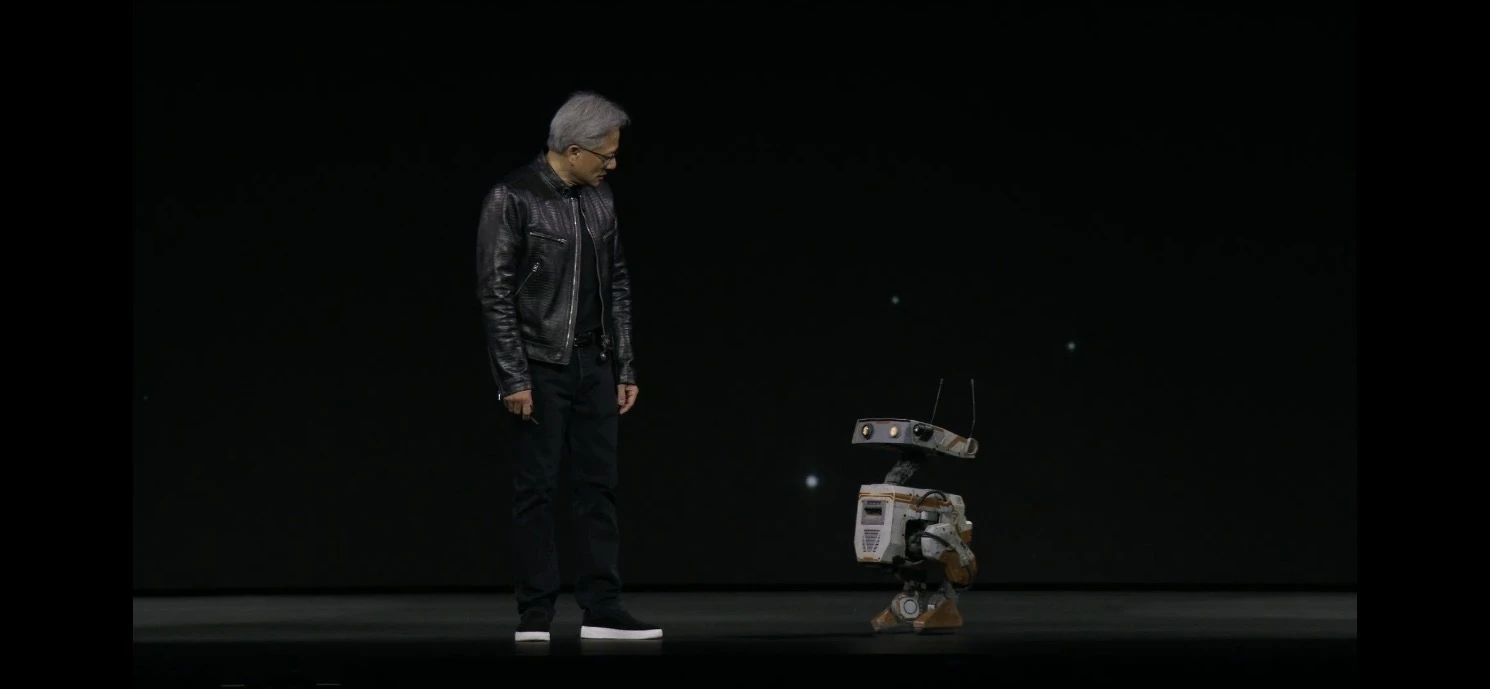

除了对于机器人的图片介绍外,现场,还展示了迪士尼的orange和green机器人。该机器人应用的是英伟达为机器人专门设计的首款AI芯片Jetson。

如果说,上一个万亿增幅空间的市场来源于算力和GPU,那么,下一个万亿增幅空间的选择上,机器人是英伟达的一条路。

2

黄仁勋干货发言回顾:向远看、向前看

英伟达成为业界公认的“产业风向标”,黄仁勋的发言也备受关注。

此前,黄仁勋曾表示,加速计算和生成式 AI 已达到一个转折点。而黄仁勋(Jensen Huang)先后参加了斯坦福商学院SIEPR经济峰会以及View From The Top 系列活动,围绕着加速计算的本质、模型训练的未来、人工智能(AGI)何时实现,AI增长需要多少额外芯片产能等方面,分享了不少真知灼见。

而在过去30多年的时间里,英伟达一直致力于一种称为加速计算的新型计算方式。研究加速计算的核心原因是,通用计算并不适合每一个工作领域,开发一种解决通用计算不擅长问题的计算方式。“事实上,我们在特定计算领域有效地做到了这一点。这本质上是算法的可以并行化。我们已经将计算机的计算成本降低到接近零。”

黄仁勋看来,AI是被加速计算所支持,可能是技术产业中最伟大的发明。AI很可能是21世纪最重要的事物。英伟达擅长的是加速计算,但英伟达的架构不仅能加速算法,而且是可编程的,这意味着你可以用它来处理SQL,他们可以加速量子物理、加速所有的流体和粒子代码等等广泛领域,其中之一才是生成式AI。

我们需要回到基本原理,思考生成式AI是什么。以往,信息被预先记录然后根据算法进行检索,而未来,信息处理的方式将从根本上发生变化。生成式AI将从一个信息“种子”出发,计算的未来将高度依赖生成而非检索。

如果在未来,内容将是AI生成式的,那么,计算形态会发生怎样的改变?

现在我们训练模型然后应用模型,再训练、再推理,在未来,我们将有持续的训练,甚至我们可以选择是否把训练的结果部署到应用中,AI通过观看视频和文本,不断地自我改进。

学习过程和训练过程。推理过程、训练过程、部署过程、应用过程将变得一体,而且这种循环将是持续的。所以,未来的AI计算机也会做类似的事情,它会合成数据,再进行强化学习,再继续以真实世界的经验为基础,它会想象一些事情,然后用真实世界的经验来测试,整个循环就是一个巨大的循环。这就是当你能够将计算成本降低到接近零时,会发生的事情。

可我们什么时候能实现AGI?黄仁勋的回答是“如果对AGI的定义是它通过人类的数学、推理、医学、律师等测试,那么我会告诉你5年内就会做得很好。如果是拥有人类般的智能,那我不确定。但我们都在努力让它变得更好。”

这就离不开芯片。那么,为了支持AI的增长,需要多少额外的芯片产能?

简单说,我们是需要更多的fab。然而,我们也在不断改进算法和处理过程,效率在时间上有了巨大的提升。并不是说计算的效率就是今天这样,因此需求就是这么多。与此同时,我每10年都在提高计算能力一百万倍,而需求却增长一万亿倍,这两者必须相互抵消。然后还有技术扩散等等,这只是时间问题,但这并不改变这样一个事实:总有一天,世界上所有的计算机都将100%地改变,每一个数据中心,价值数万亿美元的基础设施,将完全改变,然后在这之上还会建造新的基础设施。

此外,黄仁勋还提到下一个即将到来的是液冷技术。它以数据中心的规模进行计算。在未来的10年里,我们将深度学习的计算能力再提高100万倍,会发生什么在未来,我们将有持续学习。我们可以决定是否将那个持续学习的结果部署到世界上的应用中,但计算机将观察视频和新文本,并从所有互动中不断改进自己。液冷GPU将以数据中心的规模进行计算。对于未来是否愿意为一定规模的客户定制解决方案,“如果是在现有生态系统基础上扩展,我们将非常乐意。”

没有一家公司可以仅靠一股热潮就能拔地而起。在黄仁勋看来,英伟达所做的每一件事,都是在创造技术,同时创造市场。过去三十余年,英伟达向下扎根,几乎每项工作围绕技术和市场展开。同时,他们也会向上攀岩——“对于未来,我们会做更多的计算,会将计算的边际成本降低到接近零。”

正如黄仁勋曾说过的那般:“你不是为了食物而奔跑,就是为了避免成为食物而奔跑。往往你无法分辨到底是哪种情况。不管怎样,都要奔跑。”沿着AI的方向,一头算力猛兽正在狂奔,影响着“整个地球”。

Reference:

1.https://www.nvidia.cn/gtc-global/keynote/

2.黄仁勋最新2万字对话全文:未来10年算力将再提高100万倍|钛媒体AGI

3.可能是老黄信息量最大的采访 |信息平权

4.芯片制造业计算负载提速 40-60 倍,台积电部署英伟达cuLitho平台 |IT之家

免责声明:本文转载自经纬创投,文章版权归原作者所有,内容仅供参考并不构成任何投资及应用建议。